ロボットに聴覚を提供するオープンソースソフトウェアの研究開発

ロボット聴覚オープンソースソフトウェアHARK

システムと人とのインタラクションに欠かせない「声」。しかし、ロボットが自分の耳で音を聞き分けるのはかなり難しいことです。会社創設時よりこの分野に取り組んできたHRI-JPのアプローチはどんなものでしょうか?

Index

Share

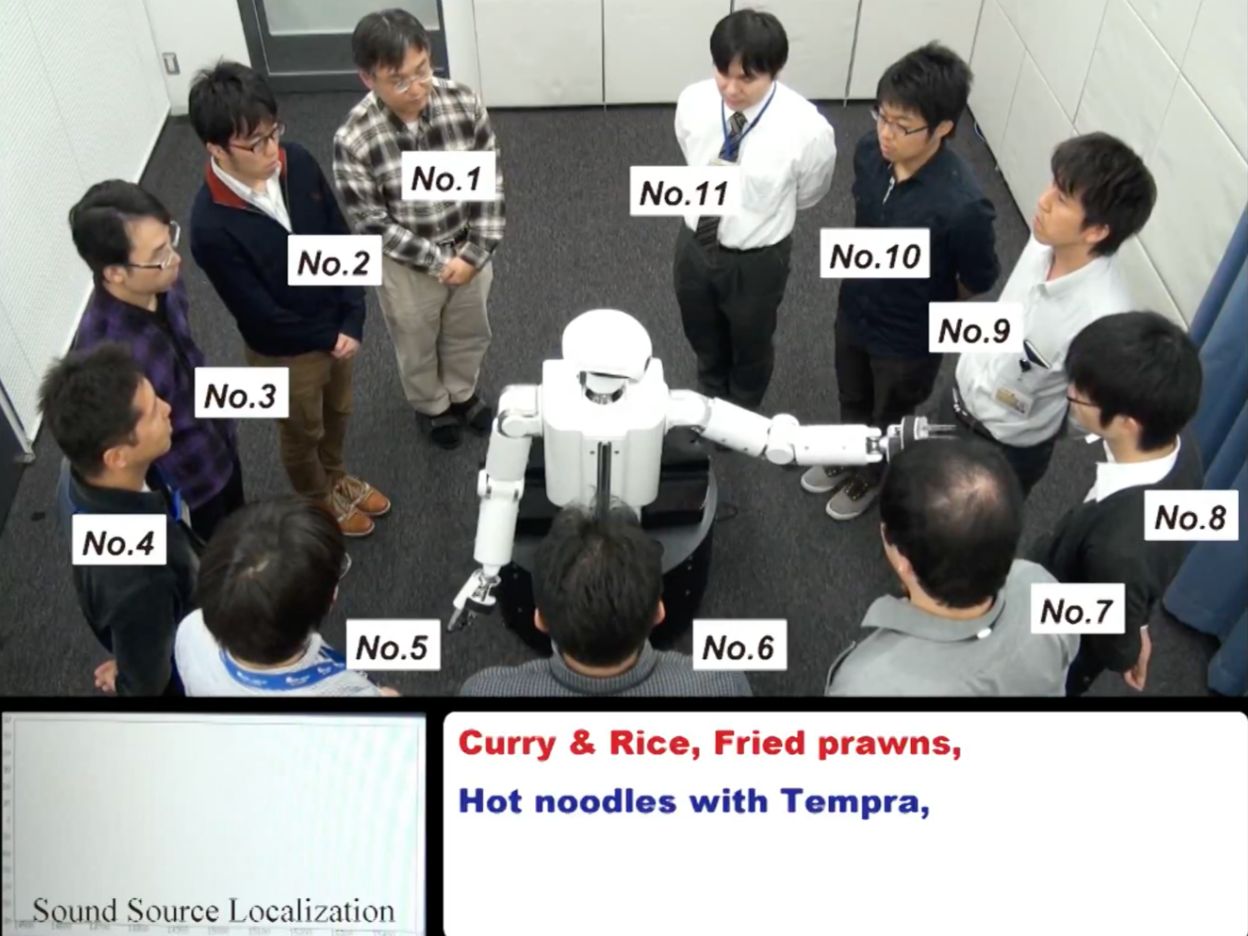

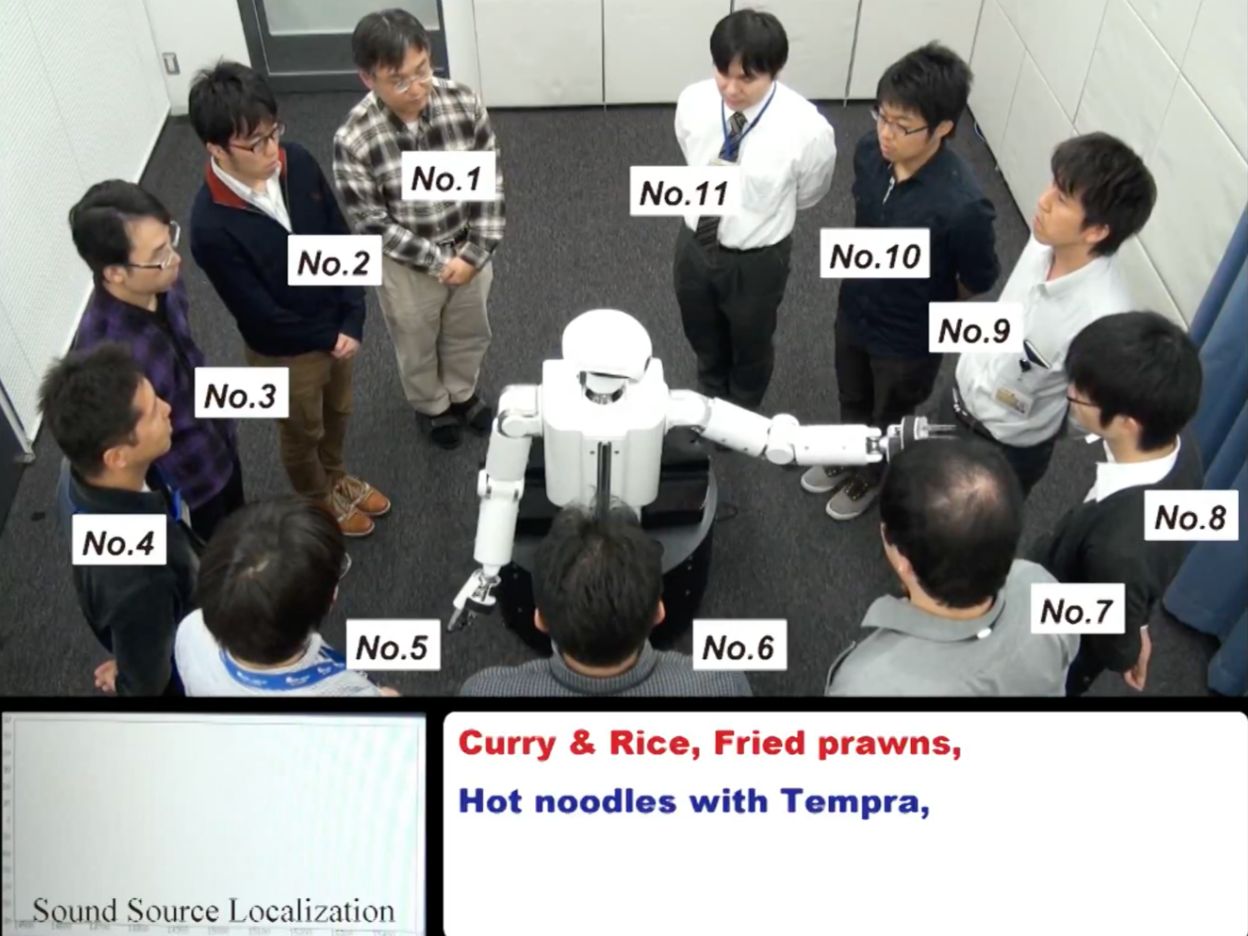

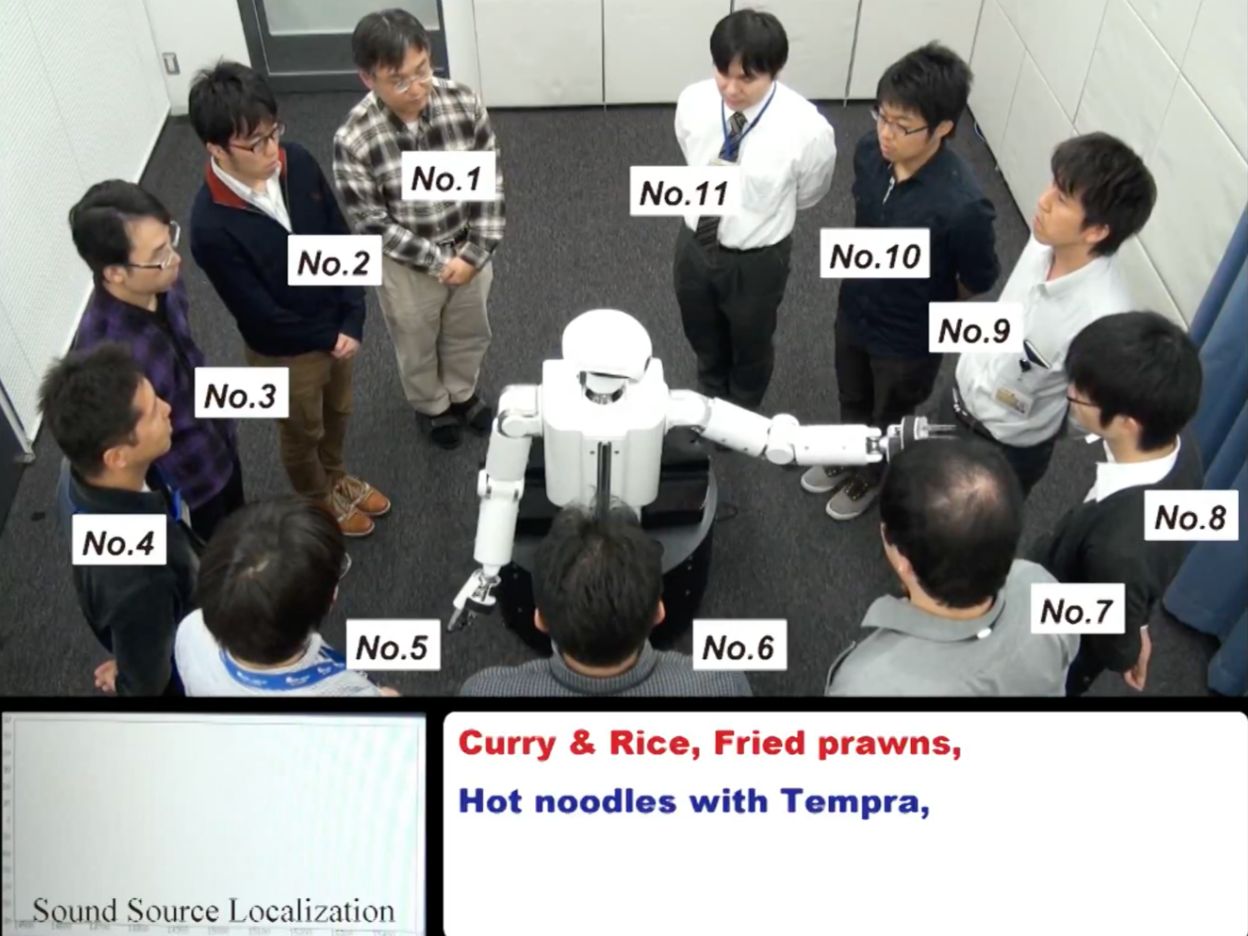

同時に発話する11人の発言内容を聞き分ける

HARKは、ロボット聴覚研究の成果として開発されたオープンソースソフトウェアです。HARKは複数のマイクを並べて使うマイクロホンアレイ処理を用いることで、ロボットに聴覚機能を提供します。具体的には、話者など各音源の位置を推定(音源定位)、それぞれを聞き分け(音源分離)、テキストに変換(音声認識)することができます。

音を聞き分けるというのは簡単なことのように思えるかもしれませんが、実際ロボットが自分の耳で音を聞き分けることはかなり難しいのです。静かな室内ならともかく、実際の人間の活動環境はさまざま。賑やかな場所では、音声など目的の音源からの音が周囲の雑音に混ざってしまい、うまく認識できないという問題があります。

また、ロボット自身はモーターの塊ですから、それ自体が雑音源となります。さらには、何が目的音源で、何が雑音源なのかも状況で変わってしまうので、聞こえてくるすべての音源をつねに把握しなければならないという難しさもあります。

ロボット自身の耳を使うのではなく、話しかける人間のほうがヘッドセットを身に着けるという回避策も考えられますが、話す度に毎回ヘッドセットを装着するのは面倒。話者が増えた場合、その人数分を用意するのも大変です。日常的に使ってもらうためには、やはりロボットが自分の耳で音を聞き分ける能力を持つべきなのです。こうした問題を解決すべく「ロボット聴覚」を日本発の研究領域として提唱して世界に発信。世界のトップランナーとして研究を続けてきました。

「百聞は一見にしかず」ということで、HARKの性能については、実際のデモ動画をご覧いただきましょう。これは、11人が同時に料理を注文するというもの。動画では、全員の音声が混じって何を言っているのかまったくわかりませんが、このロボットは、頭部に搭載した16個のマイクロホンを用いることで同時に発話された音声のそれぞれを正しく認識します。

動画タイトルにある「Prince Shotoku(聖徳太子)」とは、6世紀末から7世紀初頭に生きた日本の政治家。耳がとてもよく、何人もの話を同時に聞き分けることができたという逸話の持ち主

内部の処理としては、まず、MUSIC(Multiple Signal Classification)と呼ばれる手法を用いて、11人の話者の方向を聞き分けます。これは、雑音に頑健な音源定位手法を、独自に拡張することでさらに雑音頑健性を高めたものです。次に、「MUSICで得られた各話者の音源方向情報と話者同士の音声は互いに高次無相関(大まかにいえば、どの二つの音声を取り出しても、それらの話者および内容は異なっているという意味)である」という規範を用いた独自の音源分離手法「GHDSS-AS(Geometric High-order Decorrelation based Source Separation with Adaptive Step-size Control)」で、11人の音声が混ざっている入力信号から各音声を分離抽出します。最後に、分離した各音声を認識します。

オープンソース化し、年2万件超のダウンロード

HRI-JPは、2003年の創設時より、この研究を行ってきました。人間にとって音声や音は、最も自然なインターフェイス。ロボットやシステムが人とインタラクションするためには、欠かせない技術といえます。自動車の運転中など、手が離せないシチュエーションでも、音声なら問題なくやりとりできるというメリットもあります。

さらに研究を加速化し、成果を世の中に広めていくため、2008年にはこの技術をオープンソース化。誰でも自由にロボットやシステムに組み込めるようにしました。コンピューターによる画像処理・解析の分野には、デファクトスタンダードなツールとしてOpenCVがありますが、HARKは聴覚におけるこのような存在を目指しています。さまざまなツールを整備し、普及させるために毎年講習会も開催。ダウンロードは毎年2万件を超えています。

こういった活動を継続した結果、2014年には、IEEEのRAS(Robotics&Automation Society)において、「ロボット聴覚(Robot Audition)」が研究分野のひとつとして登録されました。日本発の研究領域が世界に認められるのに、HARKも一役買ってくれたといえます。

会議議事録作成から、生態学への応用まで

HARKは本来、ロボット用として開発されました。しかし、リアルタイムでの音源定位、音源分離、音声認識が可能という優れた特長により、いまやロボットに限らず、さまざまな分野で活用が期待されています。

まずは、会議分析。HARKなら、話者と発言を紐づけることで「いつ、誰が、どのくらい話したのか」を抽出でき、それらの情報に基づく会議の分析も可能です。すでに、学校教育や企業研修を対象に、HARKをベースとした議論分析サービスが実用化されています。

意外なところでは、生態学分野でも活用されています。いつ、どこで、どんな鳥・動物・虫が鳴いているのかという情報は非常に重要です。従来は人手に頼っていましたが、人の耳による聞き分けではどうしても聞き間違いや聞き逃しが起こります。

これまで自身の耳に頼って観測をしてきた人々からは、HARKのような技術の導入については、最初は懐疑的な声もありました。しかし、人間による観測と高い相関が得られる、人間では分析が難しいケースでも分析できる場合があるといった結果を発表するにつれ、次第に有用な技術として受け入れられるようになってきています。

HARKは、HRI-JPがその草創期から、ロボット聴覚という基礎研究を進めるなかで培われてきた技術です。その意味では、HARKはHRI-JPが活動理念として掲げる「科学を通じたイノベーション=Innovation through Science」の一つの例といえます。このようなイノベーションの芽がでてくると、前述の生態学分野への適用のように、そこから新たなサイエンスも始まり、「Science through Innovation」ともいえる流れも生まれてきます。このように「Innovation through Science」を体現する技術が創出できれば、イノベーションとサイエンスをグルグル回す、好循環もどんどん生まれてくるのです。

(c)HRI-JP次世代Intelligent Communication and Social Interaction 共同研究講座

災害現場で被災者を捜索するロボットにも搭載

もちろん、ロボット分野での活用も進んでいます。内閣府が2014年に開始した「革新的研究開発推進プログラム」(ImPACT)のプロジェクトのひとつ「タフ・ロボティクス・チャレンジ」(TRC)は、厳しい災害現場でタフに活動できるロボットを目指すプロジェクト。HARKは極限音響技術として、その中のドローンとヘビ型ロボットに搭載されました。

大規模災害時、人間が立ち入るのが難しいような状況でも、ドローンなら上空から接近し、被災者を捜索することが可能です。瓦礫の中などに埋もれている場合には、助けを求める声が発見のカギとなりますが、ドローンで問題となるのはブレードの高速回転による大きな騒音。しかしHARKであれば、騒音の中でも被災者の声を聞き分けることができます。

一方、ヘビ型ロボットは、瓦礫の中にも入っていける走破性能の高さが特徴です。モーターの騒音が救助活動の邪魔になるという同様の問題がありましたが、HARKでこれを解決。さらにIMU(慣性観測装置 )のドリフト補正として、音を使ったロボット自身の姿勢推定にも使われました。

HARKの技術はHRI-JPの他のプロジェクトや大学でも使われ、研究開発も進められています。これからも社会へのさらなる普及を目指し、活動を続けていきます。

TRCの東工大・熊本大・早大のチームが開発したHARK搭載ドローン

| 所属先名 | 担当者 |

|---|---|

| プロジェクトリーダー | ・ |

Voice

「音を聞き分ける」という、簡単そうに思えることが実は難しい。基礎的な信号処理技術の開発から、近年ホットな深層学習技術の取り込み、実時間で動作させるロボットへの実装まで、課題が多岐に渡るやりがいのある研究分野です。